di Marc Eliot Stein, World BEYOND War, 31 luglio 2023

Questa è una trascrizione completa dell'episodio 50 di World BEYOND War: un nuovo podcast.

È luglio, la calda estate del 2023. Sai chi sono, sono Marc Eliot Stein, direttore tecnologico di World Beyond War, ancora qui nelle terre Lanape di Brooklyn New York, facendo ancora la cosa giusta qui sul World Beyond War Podcast, Solo che oggi è speciale perché questo è l'episodio 50, wow un numero tondo.

Quando ho iniziato questo podcast, immagino di non aver mai nemmeno pensato se sarei mai arrivato o meno a 50 episodi. Il numero 50 di sicuro non sarebbe sembrato realistico in quel momento. Immagino che mi stavo principalmente chiedendo se avrei mai completato l'episodio numero 1, e ci sono state alcune chiamate ravvicinate con la rinuncia prima che lo facessi.

Ed eccomi qui a 50 anni, e che cosa gioiosa è, rendermi conto che abbiamo capito come far funzionare davvero questo podcast contro la guerra e abbiamo trovato un pubblico che cresce ogni mese. Sono così orgoglioso di questo podcast e sono grato a tutti coloro che ne hanno fatto parte finora.

Il podcasting è un formato creativo unico. Non è come nient'altro. Lo so perché anch'io sono un drogato di podcast. Ho almeno 20 spettacoli regolari a cui tengo davvero: storia, politica, tecnologia, musica, letteratura, TV, film. Quando sono dell'umore giusto per rilassarmi e ampliare le mie conoscenze allo stesso tempo, non c'è davvero nessun altro formato che colpisca come fa un podcast. Penso che questa sia una distinzione importante: inserisci un host e un ospite in un webinar, diciamo, o in una chat in live streaming, e avranno un tipo di conversazione, ma se metti le stesse due persone in un'intervista podcast, in qualche modo loro avrà un diverso tipo di conversazione – probabilmente più personale, più spontaneo, più sconnesso, più sul momento, meno progettato per andare verso una conclusione.

Perché è esattamente questo? Non lo so, ma il defunto filosofo dei media e della tecnologia Marshall McLuhan scrisse qualcosa nel 1964 su quanto rapidamente la nuova popolarità della televisione stesse cambiando la società moderna, e aveva ragione. Il mezzo, ha detto McLuhan, è il messaggio. Il formato è il contenuto.

Ad esempio, potresti scrivere le stesse parole su Facebook, Twitter e LinkedIn, e le parole avranno un significato particolare diverso in ciascun caso. Dal momento che i podcast celebrano la voce umana spontanea e non ascoltata, il podcasting è diventato un forum in cui l'ambivalenza umana o persino la contraddizione e l'ironia sconcertanti possono essere facilmente accolte e comprese. Immagino che questo sia un buon forum per parlare di una tendenza che è molto nelle notizie e che ho molti pensieri ambivalenti e sconcertanti che sto per condividere con voi oggi. Sto parlando di intelligenza artificiale.

Quando Marshall McLuhan disse che il mezzo è il messaggio nel 1964, quando poche persone pensavano ai modi sottili in cui la televisione e altri mezzi di trasmissione intimi da casa stavano cambiando il tessuto stesso della società umana. Oggi, un nuovo mezzo abilitato dalla tecnologia più aggiornata di oggi minaccia anche di avere un vasto impatto sulla società. Sto parlando di popolari strumenti di intelligenza artificiale generici come ChatGPT che sono disponibili per chiunque disponga di una connessione a Internet e, se non hai sentito parlare di ChatGPT, sta ricevendo molta attenzione ovunque a causa di quanto bene emula la conversazione umana e con quanta facilità può integrare e recuperare l'intero ampio spettro di conoscenze generali disponibili.

I chatbot esistono da alcuni anni: possono essere semplici e innocui come i chatbot automatizzati del servizio clienti su un sito Web BestBuy o Ticketmaster. I nuovi chatbot come ChatGPT4 non si limitano ai prodotti elettronici o ai biglietti per i concerti: si tratta di tipi molto diversi di motori di conoscenza, noti come modelli di linguaggio di grandi dimensioni, addestrati per cogliere l'intera intelligenza umana.

A volte le persone pensano che la G in ChatGPT stia per Generale, e questa sarebbe un'ipotesi decente, perché il sistema è progettato per dimostrare intelligenza generale e conoscenza generale. La G in realtà sta per Generative, il che significa che questo prodotto è progettato anche per creare cose, per generare immagini e parole originali. La P sta per pre-addestrato, di cui parleremo tra pochi minuti, e la T sta per Transformer, che non è un classico album di Lou Reed ma un modello di progettazione software che consente al modello linguistico di rispondere ai testi immessi non da elaborando una parola alla volta ma considerando ed eseguendo trasformazioni sull'intero testo immesso nel suo insieme.

Questi nuovi chatbot possono conversare su qualsiasi argomento in uno stile di conversazione amichevole, interpersonale e ricco di sfumature. I chatbot possono scrivere saggi, risolvere problemi, effettuare ricerche approfondite nel database, generare codice per computer, rispondere istantaneamente a domande difficili. ChatGPT e altre offerte simili mostrano un livello di agilità linguistica e completa che sembra far avanzare il campo dell'intelligenza artificiale più velocemente di quanto molti di noi si aspettassero. C'è stata una notizia non molto tempo fa secondo cui alcuni membri del personale di Google credevano che il proprio sistema di intelligenza artificiale potesse superare il test di Turing e diventare indistinguibile dalla comunicazione umana senziente, spaventando gli stessi esperti di Google con le sue prove di coscienza. Non so se credo personalmente che qualsiasi IA possa superare il test di Turing, ma so che molti esperti ora credono che questo stia diventando possibile.

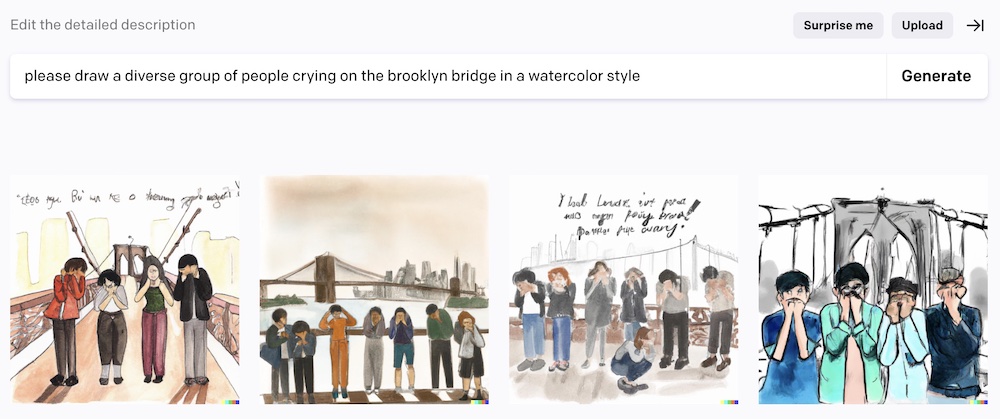

I chatbot di conoscenza generale sono tutt'altro che l'unico caso d'uso popolare per l'IA. I generatori di immagini possono creare istantaneamente opere d'arte visive dai prompt di testo, a volte immagini sorprendenti e intelligenti che richiederebbero ore, giorni o settimane per essere create da pittori fisici o artisti digitali. La generazione di immagini dai prompt di testo è una realtà oggi tramite generatori di immagini di intelligenza artificiale online gratuiti come DALL-E, di OpenAI, la stessa società della Silicon Valley che ha creato ChatGPT. Puoi immaginare un'idea e descrivere uno stile pittorico e questo servizio web ti invia magicamente una serie di diverse varianti di tentativi per catturare la tua idea.

Questa è una realtà oggi, ed è anche una realtà oggi che ChatGPT4 può scrivere saggi competenti, ponderati ed estesi su quasi tutti gli argomenti che gli vengono chiesti: saggi che potrebbero essere abbastanza buoni per conseguire diplomi universitari avanzati.

Forse è troppo presto per fare una previsione come questa, ma sembra che i chatbot intelligenti e i generatori di immagini - la scrittura generata dalla macchina e l'arte generata dalla macchina - rappresentino un'importante innovazione tecnologica e una grande innovazione sociale che influenzerà tutti noi sulla terra in un modo oppure un'altra. Chissà in che direzione sta andando il futuro in questi giorni, ma sembra almeno possibile che il lancio di ChatGPT3 nel 2022 sarà un giorno ricordato come un momento significativo nella storia culturale simile al lancio del browser Mosaic nel 1993, che ha dato il via all'intero popolare Boom di Internet in cui viviamo ancora oggi.

Sembra anche possibile, mi dispiace dirlo, che questa nuova innovazione causi nuovi tipi di gravi problemi che dovremo tutti affrontare, anche se molti di noi potrebbero pensare che la nostra società stia già annegando negli effetti collaterali indesiderati di altre innovazioni tecnologiche che non abbiamo richiesto nelle nostre vite, non abbiamo invitato nelle nostre vite, eppure che sono comunque nelle nostre vite.

Voglio trascorrere questo episodio parlando di come l'IA ci influenza come attivisti contro la guerra. Lasciatemelo dire in anticipo: l'intelligenza artificiale è un argomento caldo, molto controverso, ed è così che dovrebbe essere. Dovremmo preoccuparcene e dovremmo parlarne, e secondo me dovremmo anche aprire la mente al bene che questa tecnologia può fare.

È controverso tra i progressisti e gli attivisti ed è controverso per tutti. Dovrebbe essere controverso e non sto facendo questo episodio perché ho risposte facili su come queste recenti innovazioni possano avere un impatto sul nostro pianeta. So che avranno un impatto sul nostro mondo e so che gli attivisti contro la guerra devono parlarne. Quindi sto facendo questo episodio per iniziare la conversazione, per esporre le varie questioni diverse con cui penso che molti attivisti contro la guerra stiano probabilmente affrontando quando parlano di questo argomento, e forse per esprimere una certa comprensione di tutti i lati di questo perplessità problemi. Questo è quello che cercherò di fare qui - e quando avrai finito di ascoltare questo episodio, per favore condividi il tuo feedback sul nostro world beyond war pagina web per questo episodio, o contattandomi direttamente: sono facile da trovare.

In termini di impatto sulla vita di tutti i giorni, molti si chiedono se le straordinarie capacità dell'intelligenza artificiale faranno perdere il lavoro a molte persone. Questa è spesso la prima preoccupazione che si presenta alle persone quando vedono il potere dell'IA. Queste capacità avanzate faranno sì che vari settori di occupazione umana sana e sforzi diventino improvvisamente indesiderati? La nostra società è già fortemente sbilanciata in termini di chi lavora, chi guadagna e chi spende. Se gli ecosistemi della classe media che lavora per vivere vengono ulteriormente sconvolti perché l'IA può svolgere molti degli stessi compiti meglio e gratuitamente, possiamo essere certi che l'interruzione aumenterà il divario tra i ricchi e il resto di noi, che il 1 % sarà in grado di beneficiare del cambiamento mentre il resto di noi sarà lasciato ad affrontare le conseguenze, e che l'1% renderà anche gli strumenti di intelligenza artificiale che aiutano l'1% non disponibili per le persone che potrebbero usare il loro aiuto, o troppo costosi per loro di accedere.

Ammettiamolo, nelle economie capitaliste predatorie in cui molti di noi sono bloccati a vivere, la disoccupazione significa indebitarsi e perdere la nostra libertà di scelta, e questo è esattamente ciò per cui queste economie fortezza sociopatiche sono progettate per fare alle persone normali: toglierci il potere di scelta e farci pagare e lavorare per loro. Questa è la visione futura del capitalismo della fortezza oggi: avremo nuovi computer intelligenti e potenti, poiché noi stessi siamo impoveriti.

C'è anche il fatto che la polizia e l'esercito stanno già iniziando a utilizzare strumenti di intelligenza artificiale, insieme a nuovi robot potenti e violenti. Penso che questa possa essere la minaccia più seria e immediata che AI presenta in questo momento, e penso che i movimenti di protesta assediati dalla polizia come, ad esempio, l'importante movimento Stop Cop City ad Atlanta, in Georgia, stiano già affrontando questa realtà mutata. I sistemi di intelligenza artificiale portano i pregiudizi e i valori codificati dei loro creatori umani, quindi la polizia o i militari addestrati dall'IA minacciano di diventare letteralmente macchine per la caccia e l'uccisione di popolazioni vulnerabili, scegliendo i loro obiettivi in base all'aspetto o alla razza. In un mondo che sta già imperversando fuori controllo con la guerra dall'Ucraina allo Yemen, l'idea di potenziare una parte o l'altra - e, inevitabilmente, entrambe le parti - con nuovi tipi di macchine omicide e regimi di repressione codificati con feroci profili razziali è tanto orribile quanto sembra.

Gli scenari peggiori per la disoccupazione di massa o l'intelligenza artificiale codificata in base alla razza utilizzata dalla polizia e dalle forze militari sono orribili e non possiamo dormire su questo perché gli effetti sono già nel nostro mondo. Sta già accadendo. Quindi iniziamo questa conversazione riconoscendo che due degli orrori separati che l'IA avanzata sembra presentare - disoccupazione di massa e abusi da parte della polizia e delle forze militari - sono due modi diversi in cui potenti forze di ricchezza e privilegi radicati rubano diritti e libertà alle persone .

A proposito di ricchezza e privilegi radicati, parliamo di OpenAI, un'azienda nel nord della California che puoi trovare online su OpenAI.com. Questa azienda era poco conosciuta fino a quando non ha lanciato il generatore di immagini DALL-E nel 2021, e poi nel novembre 2022, appena nove mesi fa, ha rilasciato il suo primo chatbot pubblico, ChatGPT3, seguito rapidamente dai più potenti e capaci ChatGPT3.5 e ChatGPT4 , le versioni ora disponibili.

Sono rimasto piuttosto sbalordito quando ho visto per la prima volta le immagini che DALL-E poteva creare, e sono rimasto ancora più sbalordito la prima volta che ho provato ChatGPT. La sfida che questi strumenti stavano cercando di affrontare mi era molto familiare, perché io stesso ho studiato intensamente l'IA, come hanno fatto molti sviluppatori di software. Il mio primo incontro con l'intelligenza artificiale è stato un progetto di studio indipendente che ho svolto al college, parecchi decenni fa.

Erano gli anni '1980, e forse alcuni molto giovani saranno sorpresi di sentire che persone come me facevano lavori di intelligenza artificiale negli anni '1980, ma il termine intelligenza artificiale è vecchio quasi quanto la stessa rivoluzione informatica. Anche se i risultati dell'IA dagli anni '1950 agli anni '1990 erano infantili rispetto ai progressi che abbiamo visto negli anni successivi.

Il campo era così aperto negli anni '80, infatti, che sono stato in grado di ottenere alcuni crediti durante il mio ultimo anno come specializzazione combinata in filosofia e informatica elaborando un progetto di studio indipendente originale per un programma che avrebbe analizzato frasi in inglese e rispondere in modo da dimostrare o simulare una comprensione di base. Ho codificato in LISP su un terminale Unimatic esilarantemente ingombrante e luminoso verde collegato a un enorme mainframe Univac che aveva le dimensioni di un grande edificio e probabilmente aveva meno potenza del MacBook su cui sto registrando questo podcast in questo momento, perché è così che abbiamo girato indietro negli anni '80.

L'entusiasmante sfida del mio progetto di studio indipendente sull'intelligenza artificiale era analizzare e rispondere a frasi che includevano semplici verbi e nomi. Ad esempio, digiterei frasi come "Ho un gatto di nome Happy" e "il mio gatto è arancione" e "tutti i gatti dicono miao" nel mio programma LISP, che dimostrerebbero una certa comprensione rispondendo a domande come "Happy è arancione?" o "il gatto di Marc miagola?". Abbastanza divertente, stavo cercando di creare un chatbot AI proprio lì sul mio mainframe Univac.

Scommetto che molti altri studenti universitari stavano cercando di fare la stessa cosa in quel momento, ma nessuno di noi è andato molto lontano, perché erano gli anni '1980 e un'idea geniale chiave non ci era ancora arrivata: la rete neurale, che fornisce un software struttura progettata per eseguire semplici operazioni massicciamente parallele simili ai neuroni nel cervello umano. Mentre il mio programma LISP forniva calcoli a thread singolo e i programmi Fortran, COBOL e Pascal seguivano lo stesso paradigma a thread singolo limitato, le reti neurali fornivano thread elementari paralleli che eseguivano semplici calcoli in parallelo. Il cervello umano fa un sacco di elaborazioni parallele - operazioni simultanee a cascata per formare illusioni di singolarità - e la struttura del software nota come rete neurale consentirebbe ai programmatori di raccogliere la potenza di questa elaborazione parallela - dopo che mi sono laureato al college.

Insieme al concetto di rete neurale alla fine è arrivato il concetto di addestrare una rete neurale con attività ripetitive, un altro concetto che non ci era ancora arrivato negli anni '80. Stavo alimentando il mio programma LISP con un piccolo numero di frasi complete e non gli fornivo alcun feedback con cui correggere e migliorare le sue prestazioni. Quello che avrei dovuto fare, invece di digitare frasi nel mio terminale di computer, era fornirgli interi libri, giornali ed enciclopedie, e interagire costantemente con esso per fornire feedback al suo comportamento mentre il mio programma tentava ripetutamente di simulare le azioni più basilari e primitive di comprensione. Dandogli un sacco di materiale di lettura per costruire una base di conoscenze ricca e complessa e addestrandolo ripetutamente e accuratamente, avrei potuto effettivamente far sì che il mio programma per computer dicesse qualcosa di sorprendente sul fatto che avessi o meno un gatto arancione. Le reti neurali e l'addestramento ripetitivo, a quanto pare, hanno contribuito ad aprire la strada alle simulazioni di successo dell'intelligenza umana che vediamo oggi con i chatbot.

Noterai che parlo di simulare l'intelligenza umana. Questo indica un'altra polemica. Alcune persone trovano ridicolo il termine "intelligenza artificiale". Peggio che ridicolo, alcuni trovano l'idea eticamente preoccupante perché, se l'intelligenza dà origine alla coscienza, l'intelligenza artificiale può trasformarsi in coscienza artificiale: sensibilità artificiale, ostinazione artificiale, diritto artificiale all'esistenza. Questo sicuramente richiama molte domande esistenziali. Tutte queste domande sono valide e importanti. Alcuni si chiedono se i motori di conoscenza dell'intelligenza artificiale e i modelli linguistici potrebbero già sviluppare la coscienza. Personalmente, trovo abbastanza facile dichiarare che, no, non dobbiamo preoccuparci che i chatbot sviluppino sentimenti reali. Ci sono molti aspetti diversi dell'intelligenza artificiale di cui preoccuparsi, e questo non è uno di cui mi preoccupo personalmente. Ma questo non significa che posso provare che ho ragione e che nessuno dovrebbe preoccuparsene. Forse sono così sopraffatto da cose diverse di cui dovrei preoccuparmi che non ho tempo per preoccuparmi di questo. Non ho una risposta definitiva a tutte le domande che potrebbero sorgere sulle domande sulla sensibilità della macchina, e non ho intenzione di fingere di averla. Ma so quali sono le domande che dobbiamo capire come affrontare.

Un'opinione che a volte sento all'interno delle comunità di attivisti è che l'intelligenza artificiale equivale a un mucchio di clamore, un'illusione alimentata dalle eccellenti capacità di conversazione di un modello linguistico di grandi dimensioni. Certo, GPT può analizzare una domanda e rispondere con un'elegante fraseologia, ma perché questa felicità con il linguaggio dovrebbe farci immaginare che sia stato fatto un progresso significativo? Google e Wikipedia hanno già reso l'intera conoscenza umana facilmente disponibile gratuitamente su Internet, con costernazione dell'Enciclopedia Britannica. Stiamo ascoltando tutto questo clamore su ChatGPT semplicemente perché presenta una facciata linguistica della coscienza umana, un'illusione di cui tutti ci innamoriamo così avidamente. Penso che ci sia una certa validità qui. Forse se Google o Wikipedia fossero stati originariamente lanciati nel modo improvviso e completo di ChatGPT, forse parleremmo del lancio di Google o Wikipedia come enormi progressi nell'intelligenza umana collettiva, perché entrambi hanno già avuto un impatto sul nostro mondo.

Tuttavia, come ho accennato in precedenza quando ho parlato di reti neurali e formazione, descrivere i grandi modelli linguistici come facciate significa sottovalutare gli strati della struttura del software che devono esistere per rendere possibile questa felicità linguistica.

Ecco una domanda più grande, secondo me: esaminiamo l'etica di OpenAI e dei suoi presidi, fondatori, investitori e partner. C'è un sacco di problemi qui.

OpenAI.com è un laboratorio di ricerca finanziato privatamente che emerge dallo stesso ecosistema di incubatori tecnologici ultra-ricco e di alto livello della Silicon Valley che ci ha dato Facebook, Google, Microsoft, Amazon e Oracle. I suoi fondatori includono Elon Musk, il famoso miliardario le cui osservazioni pubbliche sociopatiche mi fanno davvero ammalare tanto quanto fanno ammalare molte altre persone. Elon Musk non è mai stato direttamente coinvolto in OpenAI, ed è passato ad altre cose come mostrare la sua personalità offensiva su tutti i social media, quindi questo è tutto ciò che voglio dire su Elon Musk oggi.

Per come la vedo io, è ancora più dannoso che OpenAI sia strettamente coinvolto con Microsoft, un grande profittatore di guerra e un grande profittatore nel campo dell'intelligenza artificiale per la guerra. Questa inquietante associazione è ciò di cui spero che le persone si preoccuperanno, anche più della connessione con Elon Musk. Dovremmo essere molto turbati dal fatto che il volto amichevole di DALL-E e OpenAI sia un'utile facciata per almeno un profittatore di guerra enormemente influente e malvagio, Microsoft, che sta già sviluppando il tipo di applicazioni di intelligenza artificiale militare e di polizia con codice razziale di cui abbiamo parlato circa sopra. Questo sta già accadendo dietro le quinte di Microsoft e di altri giganti tecnologici statunitensi che sono profondamente legati alla macchina da guerra statunitense. E questa è la peggiore notizia a cui riesco a pensare.

Noi del movimento contro la guerra non possiamo voltare le spalle all'intelligenza artificiale a causa del suo potenziale malvagio. Ovviamente non intendo dire che tutti i membri del movimento contro la guerra debbano consentire l'invasione tecnologica nelle proprie vite. Sono contento che molti progressisti e attivisti facciano una scelta valida per evitare le innovazioni tecnologiche alla moda nelle loro vite. Posso relazionarmi e rispettare questo atteggiamento, anche se io stesso sono lontano da uno stile di vita senza tecnologia. La tecnologia è il mio campo, la mia carriera, e come tecnologo sono affascinato dal genio, dalla creatività e dall'innovazione che si celano dietro attività come l'intelligenza artificiale.

Inoltre, semplicemente come persona curiosa, sono assolutamente interessato a ottenere informazioni sull'intelligenza umana imparando come sono stati realizzati i computer per simularla. Permetto anche a ChatGPT di entrare nella mia vita perché ho scoperto quanto sia utile. Vado su OpenAI.com e gli faccio costantemente domande. Uso ChatGPT per scrivere codice, incluso Javascript per una nuova versione della nostra mappa interattiva delle basi militari straniere statunitensi su cui sto lavorando quest'estate insieme ad altre persone di World Beyond War.

Diciamo che voglio ripulire un parametro della stringa di query rimuovendo i caratteri speciali con un'espressione regolare, che è qualcosa che avrei usato per chiedere a Stack Overflow, e metterei insieme il mio codice funzionante dai frammenti consigliati pubblicati in un thread di conversazione . Invece, ora dico a ChatGPT quello che voglio e ChatGPT sputa semplicemente Javascript perfettamente formattato, eseguibile e privo di errori. La maggior parte dei miei amici sviluppatori di software usa ChatGPT per scrivere codice ora – so che lo facciamo perché ci piace parlarne. Non credo che nessuno di noi programmatori sia ancora preoccupato che ChatGPT ci sostituirà, perché siamo noi a dover mettere insieme i pezzi di codice per creare sistemi funzionanti e GPT sta solo producendo pezzi di codice. Ma mi chiedo come questo cambierà il modo in cui lavorano gli sviluppatori di software. Sicuramente sta già cambiando il gioco.

Uso anche ChatGPT per cercare cose online nel modo in cui avrei usato Google, e lo uso per suggerimenti, prospettive e informazioni di base su cose di cui sto scrivendo o su cui sto pensando. Non sto scherzando quando dico che lo uso per tutto – come quando ho menzionato il filosofo della tecnologia degli anni '1960 Marshall McLuhan sopra, ovviamente ho chiesto a ChatGPT alcune informazioni su Marshall McLuhan, ed è ChatGPT che mi ha detto che il 1964 è stato l'anno in cui ha pubblicò il libro che diceva “il mezzo è il messaggio”.

Il fatto che così tanti di noi siano già passati da Google a GPT per le ricerche di base su Internet la dice lunga. È molto facile iniziare a permettere a questi nuovi tipi di strumenti di entrare lentamente e impercettibilmente nelle nostre vite, anche se ci preoccupiamo delle implicazioni e delle motivazioni dietro di loro.

Come la tecnologia software alla base della stessa Internet, che è stata creata per motivi dubbi dalle forze armate statunitensi ma ha continuato a causare cambiamenti sociali e trovare nuovi casi d'uso che erano completamente al di fuori del regno del suo scopo originale, questa nuova tecnologia sta per trovare il proprio percorso per influenzare le nostre vite. Questa nuova tecnologia è reale, funziona troppo bene per essere ignorata ed è qui per restare. Ancora una volta, è per questo che sto trascorrendo un episodio a parlarne con gli attivisti contro la guerra, perché fa già parte della nostra realtà e potremmo aver bisogno di alcuni dei poteri se offerti per portare a termine il nostro lavoro qui sulla terra.

Passiamo un minuto a riflettere sui molti aspetti della vita su questo pianeta che non hanno i terribili problemi di cui noi attivisti contro la guerra siamo così consapevoli. Arti, musica, letteratura, biologia, chimica, fisica, geologia, astronomia, medicina, salute, manifattura, agricoltura, alimentazione. In tutti questi mondi, tutti questi sforzi ... il lancio pubblico di un chatbot di conoscenza generale altamente capace sta avendo un impatto importante. Non c'è campo che non tocchi.

Sul piano della pacifica convivenza umana - un piano in cui vorrei poter trascorrere più tempo esistendo su me stesso - l'intelligenza artificiale è un progresso miracoloso delle capacità umane che promette grandi benefici. Se solo vivessimo in un mondo pacifico, sicuro ed equo, potremmo godere meglio insieme delle meraviglie che l'intelligenza artificiale può produrre.

Vediamo alcune di queste meraviglie quando lavoriamo con un generatore di immagini e creiamo immagini straordinariamente intelligenti o creative basate sui nostri suggerimenti che altrimenti non saremmo in grado di produrre. Sentiamo anche il paradosso sul fatto che gli strumenti di intelligenza artificiale possano o meno essere usati a fin di bene. Come tecnico, credo che non sia l'innovazione tecnologica il problema sul pianeta terra nel 21° secolo. Accolgo sempre con favore l'innovazione tecnologica e penso che i pericoli che l'IA presenta siano dovuti al capitalismo radicato e alla guerra - al fatto che questo è un pianeta in guerra con se stesso, un pianeta dominato da un ricco 1% che non può resistere a mettersi in gioco il percorso suicida di costruire società fortezza militarizzate che sopprimono altri esseri umani per mantenere i privilegi. Quello che dobbiamo fare è guarire la nostra società - quello che non dobbiamo fare è scappare dai progressi tecnologici perché fraintendiamo le cause della nostra agonia e della nostra traiettoria suicida.

Questo è quello che penso. Ovviamente non è quello che pensano tutti gli attivisti contro la guerra, e va bene così. Abbiamo avuto alcune reazioni interessanti sul World Beyond War lista di discussione e-mail – che è un forum vivace e intelligente a cui consiglio di partecipare a chiunque, basta fare clic sul collegamento sul nostro sito Web o cercare world beyond war lista di discussione - dopo che qualcuno ha condiviso alcune immagini contro la guerra davvero fantasiose che erano state generate con DALL-E, e qualcun altro ha condiviso alcune parole sorprendentemente utili su come il nostro pianeta malato può trovare percorsi per la pace nel mondo.

Credo che gli attivisti dovrebbero padroneggiare tutte le tecnologie disponibili - che l'attivismo non dovrebbe mettersi nella posizione di essere meno capace di utilizzare tecnologie innovative avanzate rispetto ai governi corrotti e alle società avide che hanno l'abitudine di opprimerci.

Credo anche che possiamo anche raccogliere sorprendenti verità filosofiche sulla coscienza umana e sull'esistenza umana studiando gli algoritmi e i modelli di progettazione utilizzati per modellarla e simularla. Passare solo qualche minuto a scherzare con ChatGPT sul sito Web OpenAI può rivelare alcune verità selvagge sulla natura umana.

Ecco una cosa selvaggia su cui sto ancora avvolgendo il cervello. ChatGPT a volte mente. Inventa cose. Di solito non lo vedrai quando inizi a mettere in discussione GPT, perché di solito fornisce una risposta potente alla prima domanda in un thread di conversazione. GPT quindi ti tiene al passo mentre fai domande di follow-up, ed è qui che è possibile riportare GPT in un angolo dove inizia a mentire. Una delle prime domande che ho fatto a ChatGPT è stata di parlarmi dei migliori podcast contro la guerra, perché, naturalmente, il mio ego era impegnato e volevo vedere se il World Beyond War podcast verrebbe visualizzato nell'elenco.

Ora, poiché GPT è pre-addestrato, ovvero è stato pre-addestrato e non viene più aggiornato attivamente con notizie e informazioni molto attuali, quindi non mi aspetto che sappia molto sul mio piccolo podcast. Inoltre, non volevo distorcere i risultati mostrando a GPT che ero interessato a un particolare podcast, quindi gli ho chiesto se esistessero ottimi podcast contro la guerra e mi ha assicurato che ce n'erano davvero. Ho quindi iniziato a entrare nei dettagli, sperando di spingerlo a nominare il World Beyond War podcast chiedendo – puoi parlarmi di podcast che hanno intervistato noti attivisti come Medea Benjamin. Qui è dove le cose iniziano a diventare divertenti. Una volta che il sistema fa un'affermazione, proverà a sostenerla, quindi dopo avermi assicurato che c'erano davvero dei podcast che avevano intervistato Medea Benjamin, gli ho chiesto di nominare uno di questi podcast, e poi mi ha detto che Medea Benjamin era l'ospite del suo podcast. Ehm, non lo è! Se lo fosse, lo ascolterei sicuramente. Sono stato in grado di convincere ChatGPT a mentire mettendolo in un angolo dove aveva bisogno di fornire informazioni che non aveva, quindi ha inventato informazioni che sembravano realistiche.

Questo accade più spesso di quanto si possa pensare. Puoi anche facilmente cogliere ChatGPT in errore lanciandogli informazioni vere ma contraddittorie. Dopo che GPT mi ha correttamente informato che Marshall McLuhan ha introdotto la citazione "Il mezzo è il messaggio" nel 1964, mi sono ricordato che questo brillante e acuto filosofo aveva anche scritto una sorta di seguito ironico al suo libro precedente che affrontava i temi più oscuri e inquietanti modi in cui i media possono addormentare le menti umane, le popolazioni spaventose del controllo della popolazione di massa aziendale attraverso i media - perché Marshall McLuhan era davvero fantastico, ha capito questo pericolo già negli anni '1960 e ha pubblicato un altro libro nel 1967 con l'artista Quentin Fiore chiamato “Il medium è il massaggio”.

Quindi ecco dove le cose sono diventate strane con GPT. Ho chiesto a ChatGPT di parlarmi della citazione di Marshall McLuhan "il mezzo è il massaggio"... e GPT mi ha informato categoricamente che McLuhan non aveva detto "il mezzo è il massaggio" ma piuttosto aveva detto "il mezzo è il messaggio". Chiaramente, GPT pensava che il massaggio fosse un errore di battitura. Ho quindi informato GPT che non era corretto e che McLuhan aveva effettivamente detto sia "il mezzo è il messaggio" sia "il mezzo è il massaggio". Non appena l'ho detto, ChatGPT si è reso conto del suo errore e si è scusato e mi ha informato che, sì, "il mezzo è il massaggio" era un libro che aveva scritto nel 1967.

Allora perché ha sbagliato prima, e soprattutto perché ha sbagliato quando aveva già accesso alla risposta giusta alla sua portata? Bene, qui è dove GPT sta iniziando a rivelare verità sorprendenti su noi stessi, perché in realtà i due errori o comportamenti scorretti di GPT lo hanno fatto sembrare più umano, non meno. Ricorda che G in GPT sta per generativo. Il sistema è progettato per generare risposte quando non è sicuro della risposta corretta. Potrebbe dirti il titolo di un film o di un libro che non esiste, ma sarà un titolo che sembra possa esistere. Se hai una lunga conversazione aperta con ChatGPT su qualsiasi argomento di cui sai molto, vedrai subito che comincerà a commettere errori.

Il modo in cui sono stato in grado di manovrare GPT in un angolo ponendogli domande di follow-up alle sue stesse risposte, inducendolo infine a generare informazioni apparentemente realistiche ma false nel tentativo di sostenere le sue affermazioni precedenti non mi è sembrato disumano, ma completamente umano.

Vediamo qui il potere schietto degli stili di argomentazione retorici e manipolativi. Forse quello che possiamo imparare da questo sorprendente comportamento scorretto di ChatGPT è che è umanamente impossibile apprendere la verità senza fabbricare verità in un modo o nell'altro, e se non stiamo attenti queste verità fabbricate che usiamo per scopi retorici possono diventare bugie che siamo costretto a difendersi con più invenzioni. Ragazzo, questo mi sembra davvero realistico.

Ancora più realistico: sappiamo che il comportamento umano di ChatGPT include la menzogna. Eppure ci fidiamo! Continuo persino a usarlo da solo, perché, davvero, sono abbastanza sicuro di me da credere che sarò sempre in grado di rilevare quando GPT si sta sforzando per una risposta e genera informazioni false. Ehi, forse mi sto prendendo in giro, e forse dovrei pensare alla mia propensione a credere a verità inventate e alla mia propensione a consentire la menzogna negli altri.

Ecco un modo in cui GPT ci rende più intelligenti, sottolineando i modi in cui ci impegniamo con falsità, facciate, bugie bianche e inganni amichevoli nelle nostre normali relazioni umane. Per dirla in poche parole: ChatGPT non può simulare il comportamento umano senza a volte mentire. Questa è una cosa infernale per tutti noi a cui pensare.

Ecco qualcos'altro a cui pensare: come stiamo facendo noi umani in termini di tenere il passo con le innovazioni tecnologiche che definiscono le nostre società? Negli ultimi anni, ci stiamo adeguando ai progressi dell'intelligenza artificiale mentre assorbiamo l'invenzione della blockchain, un nuovo metodo tecnologico per costruire database condivisi con nuovi concetti di proprietà, accesso e convalida. Abbiamo fatto un episodio precedente tutto sulla blockchain, e personalmente sono abbastanza sicuro che la maggior parte delle persone che conosco ancora non capisca il modo in cui la blockchain sta cambiando le nostre vite e cambierà le nostre vite in futuro - e ora abbiamo un linguaggio ampio modelli e motori di conoscenza generale per cambiare la nostra vita e anche il nostro futuro! Metti questo in cima a, hmm ... dove vado anche qui ... il progetto del genoma umano, i grandi progressi nella scienza del cervello, l'esplorazione e la colonizzazione dello spazio ... ehi, compagni umani, stiamo tenendo il passo con tutto questo?

Ora mettiamoci dentro le dispute tecnologiche e scientifiche su pandemie come il COVID, e non fermiamoci qui, ma passiamo a considerare la situazione delle armi nucleari ampiamente disponibili nelle mani di cosiddetti governi corrotti e incompetenti gestiti da burocrati anziani, e la politica di distruzione reciproca assicurata.

Stiamo tenendo il passo con questo? No, ma questa merda sta al passo con noi e ha il nostro numero. Ogni mattina mi sveglio e leggo della guerra per procura tra NATO e Russia che sta tragicamente uccidendo i poveri esseri umani che vivono in Ucraina. E ogni mattina mi chiedo se questo è il giorno in cui l'incompetenza dei nostri cosiddetti leader causerà l'inizio della guerra nucleare - ogni giorno mi chiedo se questo sia l'ultimo giorno per la vita umana sul pianeta terra.

È la calda estate del 2023. È uscito un nuovo film intitolato "Oppenheimer" sullo scienziato il cui lavoro ha portato all'incredibile orrore dell'omicidio istantaneo di centinaia di migliaia di esseri umani a Hiroshima e Nagasaki in Giappone nel 1945. Non credo nessuno di noi è ancora riuscito ad espandere le proprie menti abbastanza da comprendere il male assoluto, le verità scioccanti e insopportabili degli errori che le nostre società hanno commesso - e della nostra incapacità di migliorare noi stessi e sollevarci dalla nostra patetica, vergognosa dipendenza sociale da odio di massa e violenza di massa.

Ho menzionato sopra che alcune persone chiedono se l'intelligenza artificiale possa o meno portare alla coscienza e/o alla sensibilità - se un sistema di intelligenza artificiale possa mai sviluppare emozioni e sentimenti, e cosa significano queste parole e queste domande. Non ho ancora visto il film Oppenheimer e mi sento piuttosto disgustato dall'idea di un film sull'omicidio di massa in Giappone che non mostri i volti delle vittime giapponesi. Invece di chiedermi se i sistemi di intelligenza artificiale siano o meno senzienti, tutto quello che voglio dire è che ogni singola persona incenerita a Hiroshima e Nagasaki era senziente e cosciente. Questa è una verità che non credo siamo ancora riusciti ad affrontare. Forse dobbiamo allenare un po' di più le nostre menti su questo.

Ed è qui che finiamo oggi. Gli esseri umani non possono gestire la verità sui problemi che abbiamo creato e sui cambiamenti che dobbiamo apportare per migliorare noi stessi. Nemmeno i robot possono gestire la verità. Grazie per aver condiviso questo spazio con me mentre rifletto sui misteri e le ironie dell'esistenza umana, e ci porterò fuori con la voce umana di una cantante e cantautrice che amo da molto tempo, Sinead O'Connor, e una canzone chiamata The Healing Room. Grazie per aver ascoltato l'episodio 50. Ci vediamo presto per il 51.

World BEYOND War Podcast su iTunes

World BEYOND War Podcast su Spotify

World BEYOND War Podcast su Stitcher

World BEYOND War Feed RSS Podcast