Марк Элиот Стайн, World BEYOND War, 31 июля 2023 г.

Это полная стенограмма эпизода 50 из World BEYOND War: новый подкаст.

Июль, жаркое лето 2023 года. Вы знаете, кто я, я Марк Элиот Стейн, технический директор World Beyond War, все еще здесь, в землях Ланапе в Бруклине, Нью-Йорк, все еще поступая правильно здесь, на World Beyond War Подкаст, За исключением того, что сегодня особенный, потому что это 50 серия, вау, круглое число.

Когда я запускал этот подкаст, мне кажется, я даже не думал о том, доберусь ли я когда-нибудь до 50 эпизодов. В то время цифра 50 точно не казалась реалистичной. Думаю, мне в основном было интересно, закончу ли я когда-нибудь эпизод номер 1, и до того, как я это сделал, было несколько попыток сдаться.

И вот мне 50, и какое это радостное чувство — осознавать, что мы придумали, как заставить работать этот антивоенный подкаст, и нашли аудиторию, которая растет с каждым месяцем. Я так горжусь этим подкастом, и я благодарен всем, кто до сих пор был его частью.

Подкастинг — уникальный творческий формат. Это не похоже ни на что другое. Я знаю это, потому что сам увлекаюсь подкастами. У меня есть как минимум 20 регулярных передач, которые мне действительно небезразличны — об истории, политике, технологиях, музыке, литературе, телевидении, кино. Когда я в настроении расслабиться и одновременно расширить свои знания, на самом деле нет другого формата, который поражает так, как подкаст. Я думаю, это важное различие: поместите ведущего и гостя, скажем, на вебинар или в чат в прямом эфире, и у них будет один тип разговора, но если вы поместите тех же двух людей в интервью подкаста, каким-то образом они у вас будет другой вид беседы – возможно, более личный, более спонтанный, более бессвязный, более актуальный, менее направленный на то, чтобы прийти к заключению.

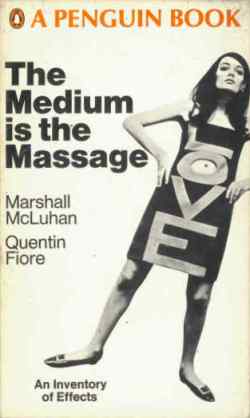

Почему именно это? Я не знаю, но покойный философ средств массовой информации и технологий Маршалл Маклюэн написал что-то в 1964 году о том, как быстро новая популярность телевидения меняет современное общество, и он был прав. Средством, по словам Маклюэна, является сообщение. Формат — это содержание.

Например, вы можете написать одни и те же слова в Facebook, Twitter и LinkedIn, и в каждом случае эти слова будут иметь разное значение. Поскольку подкасты прославляют спонтанный и необработанный человеческий голос, подкастинг стал форумом, где можно легко приветствовать и понимать человеческую амбивалентность или даже озадачивающие противоречия и иронию. Я думаю, что это хороший форум, чтобы поговорить о тенденции, которая очень часто упоминается в новостях, и о которой у меня есть много двойственных и сбивающих с толку собственных мыслей, которыми я хочу поделиться с вами сегодня. Я говорю об искусственном интеллекте.

Когда Маршалл Маклюэн сказал, что медиум — это сообщение, еще в 1964 году, когда мало кто задумывался о том, как телевидение и другие интимные средства домашнего вещания меняют саму ткань человеческого общества. Сегодня новая среда, созданная с помощью самых современных технологий, также угрожает оказать огромное влияние на общество. Я говорю о популярных инструментах искусственного интеллекта общего назначения, таких как ChatGPT, которые доступны любому, у кого есть подключение к Интернету, и если вы не слышали о ChatGPT, он привлекает много внимания повсюду из-за того, насколько хорошо он имитирует человеческий разговор. и как легко он может интегрировать и извлекать весь широкий спектр доступных общих знаний.

Чат-боты существуют уже несколько лет — они могут быть такими же простыми и безобидными, как дружелюбные автоматизированные чат-боты для обслуживания клиентов на веб-сайтах BestBuy или Ticketmaster. Новые чат-боты, такие как ChatGPT4, не ограничиваются электронными продуктами или билетами на концерты — это совершенно разные типы двигателей знаний, известных как большие языковые модели, обученные охватывать весь человеческий интеллект.

Иногда люди думают, что буква G в ChatGPT означает «Общие», и это было бы правильным предположением, потому что система предназначена для демонстрации общего интеллекта и общих знаний. На самом деле буква G означает Генеративный, что означает, что этот продукт также предназначен для создания вещей — для создания оригинальных изображений и слов. Буква P означает предварительно обученный, о котором мы поговорим через несколько минут, а буква T означает Transformer, который является не классическим альбомом Лу Рида, а шаблоном проектирования программного обеспечения, позволяющим языковой модели реагировать на вводимый текст не обрабатывая по одному слову, а рассматривая и выполняя преобразования всего введенного текста в целом.

Эти новые чат-боты могут общаться на любые темы в дружеском, межличностном, тонком разговорном стиле. Чат-боты могут писать эссе, решать проблемы, выполнять глубокий поиск в базе данных, генерировать компьютерный код и мгновенно отвечать на сложные вопросы. ChatGPT и другие подобные предложения демонстрируют уровень лингвистической и всесторонней гибкости, который, кажется, продвигает область искусственного интеллекта быстрее, чем многие из нас ожидали. Недавно появилась новость о том, что некоторые сотрудники Google считают, что их собственная система искусственного интеллекта может пройти тест Тьюринга и стать неотличимой от разумного человеческого общения, напугав собственных экспертов Google своими свидетельствами существования сознания. Я не знаю, верю ли я лично, что любой ИИ может пройти тест Тьюринга, но я знаю, что многие эксперты теперь верят, что это становится возможным.

Чат-боты с общими знаниями — далеко не единственный популярный вариант использования ИИ. Генераторы изображений могут мгновенно создавать визуальные произведения из текстовых подсказок — иногда поразительные, умные изображения, на создание которых у физических художников или цифровых художников уходили бы часы, дни или недели. Создание изображений из текстовых подсказок сегодня стало реальностью с помощью бесплатных онлайн-генераторов изображений с искусственным интеллектом, таких как DALL-E, от OpenAI, той же компании из Кремниевой долины, которая создала ChatGPT. Вы можете придумать идею и описать стиль рисования, и этот веб-сервис волшебным образом пришлет вам кучу различных вариантов попыток запечатлеть вашу идею.

Сегодня это реальность, и сегодня реальностью также является то, что ChatGPT4 может писать профессиональные, вдумчивые, обширные эссе практически на любую тему, о которой их спрашивают — эссе, которые могут быть достаточно хороши, чтобы получить высшее образование.

Может быть, еще слишком рано делать такие прогнозы, но кажется, что интеллектуальные чат-боты и генераторы изображений — машинное письмо и машинное искусство — представляют собой крупную техническую инновацию и крупную социальную инновацию, которая повлияет на всех нас на земле одним способом. или другие. Кто знает, в каком направлении движется будущее в наши дни, но кажется, по крайней мере, возможным, что запуск ChatGPT3 в 2022 году когда-нибудь запомнится знаменательным моментом в истории культуры, подобным запуску браузера Mosaic в 1993 году, который положил начало всему популярному Интернет-бум, в котором мы все еще живем сегодня.

Также представляется возможным, я обеспокоен, что эта новая инновация вызовет новые виды серьезных проблем, с которыми нам всем придется иметь дело, даже если многие из нас могут чувствовать, что наше общество уже тонет в нежелательных последствиях последствий другие технологические инновации, которых мы не просили в своей жизни, не приглашали в нашу жизнь, но которые все равно присутствуют в нашей жизни.

Я хочу посвятить этот выпуск разговору о том, как ИИ влияет на нас как на антивоенных активистов. Позвольте мне сказать сразу: ИИ — горячая тема, очень спорная, и так и должно быть. Мы должны беспокоиться об этом, и мы должны говорить об этом, и, по моему мнению, мы также должны открыть свой разум для того добра, которое может принести эта технология.

Это спорно среди прогрессистов и активистов, и это спорно для всех. Это должно быть спорным, и я не делаю этот эпизод, потому что у меня есть простые ответы о том, как эти недавние инновации могут повлиять на нашу планету. Я знаю, что они повлияют на наш мир, и я знаю, что антивоенным активистам нужно говорить об этом. Так что я делаю этот эпизод, чтобы начать разговор, чтобы изложить различные проблемы, с которыми, я думаю, сталкиваются многие антивоенные активисты, когда они говорят об этой теме, и, возможно, чтобы выразить некоторое понимание всех сторон этой запутанной ситуации. проблемы. Это то, что я попытаюсь сделать здесь, и когда вы закончите слушать этот эпизод, пожалуйста, поделитесь своими отзывами на нашем world beyond war на веб-странице этого эпизода или связавшись со мной напрямую – меня легко найти.

Что касается влияния на повседневную жизнь, многие задаются вопросом, оставят ли удивительные возможности искусственного интеллекта многих людей без работы. Часто это первое, что приходит в голову людям, когда они видят мощь ИИ. Будут ли эти продвинутые способности способствовать тому, чтобы различные сферы полезной занятости людей вдруг стали нежелательными? Наше общество уже сильно разбалансировано с точки зрения того, кто работает, кто зарабатывает, а кто тратит. Если экосистемы среднего класса, работающие на жизнь, будут еще больше нарушены из-за того, что ИИ может выполнять многие из тех же задач лучше и бесплатно, мы можем быть уверены, что разрушение увеличит разрыв между богатыми и остальными из нас, что 1 % смогут извлечь выгоду из изменений, в то время как остальным придется столкнуться с последствиями, и что 1% также сделает инструменты ИИ, помогающие 1%, недоступными для людей, которые могли бы воспользоваться их помощью, или слишком дорогими для них. их для доступа.

Посмотрим правде в глаза, в хищнической капиталистической экономике, в которой многие из нас застряли, безработица означает влезание в долги и потерю свободы выбора, и это именно то, что эти социопатические экономики-крепости призваны сделать с обычными людьми — лишить нас власти. выбора и заставить нас платить им и работать на них. Это будущее видение капитализма-крепости сегодня: у нас будут новые умные и мощные компьютеры, поскольку мы сами обеднели.

Есть также тот факт, что полиция и военные уже начинают использовать инструменты искусственного интеллекта, наряду с новыми мощными и жестокими роботами. Я думаю, что это может быть самая серьезная и непосредственная угроза, которую ИИ представляет прямо сейчас, и я думаю, что протестные движения, осаждаемые полицией, такие как, скажем, важное движение Stop Cop City в Атланте, штат Джорджия, уже имеют дело с этой изменившейся реальностью. Системы ИИ несут в себе предубеждения и закодированные значения своих создателей-людей, поэтому обученные ИИ полицейские или военные угрожают стать буквальными охотничьими и смертоносными машинами для уязвимых слоев населения, выбирая свои цели на основе внешности или расы. В мире, который уже вышел из-под контроля из-за войн от Украины до Йемена, идея наделения той или иной стороны — и, неизбежно, обеих сторон — новыми видами машин убийства и режимами подавления, закодированными порочным расовым профилированием, ужасна, как звучит.

Наихудшие сценарии массовой безработицы или искусственного интеллекта с расовым кодом, используемого полицией и вооруженными силами, ужасны, и мы не можем спать на этом, потому что последствия уже есть в нашем мире. Это уже происходит. Итак, давайте просто начнем этот разговор с признания того, что два отдельных ужаса, которые, кажется, представляет передовой ИИ — массовая безработица и злоупотребления со стороны полиции и вооруженных сил — это два разных способа, которыми могущественные силы укоренившегося богатства и привилегий крадут права и свободы у людей. .

Говоря об укоренившемся богатстве и привилегиях — давайте поговорим об OpenAI, компании из Северной Калифорнии, которую вы можете найти в Интернете по адресу OpenAI.com. Эта компания была малоизвестна до тех пор, пока в 2021 году они не запустили генератор изображений DALL-E, а затем в ноябре 2022 года, всего девять месяцев назад, они выпустили своего первого общедоступного чат-бота ChatGPT3, за которым вскоре последовали более мощные и функциональные ChatGPT3.5 и ChatGPT4. , доступные сейчас версии.

Я был потрясен, когда впервые увидел изображения, которые может создавать DALL-E, и был поражен еще больше, когда впервые попробовал ChatGPT. Задача, которую пытались решить эти инструменты, была мне хорошо знакома, потому что я сам интенсивно изучал ИИ, как и многие разработчики программного обеспечения. Мое первое знакомство с искусственным интеллектом произошло в ходе независимого учебного проекта, который я выполнил в колледже несколько десятков лет назад.

Это были 1980-е, и, возможно, некоторые очень молодые люди будут удивлены, узнав, что такие люди, как я, занимались ИИ в 1980-х, но термин «искусственный интеллект» почти так же стар, как и сама компьютерная революция. Несмотря на то, что достижения ИИ с 1950-х по 1990-е годы были инфантильными по сравнению с достижениями, которые мы наблюдаем в последующие годы.

Фактически, в 80-х годах эта область была настолько открытой, что я смог получить несколько кредитов на последнем курсе по специальности «философия и компьютерные науки», подготовив оригинальный независимый учебный проект для программы, которая анализировала бы предложения на английском языке и отвечать таким образом, который демонстрирует или имитирует базовое понимание. Я программировал на LISP на уморительно громоздком терминале Unimatic, светящемся зеленым, подключенном к массивному мэйнфрейму Univac, который был размером с большое здание и, вероятно, имел меньшую мощность, чем MacBook, на котором я записываю этот подкаст прямо сейчас, потому что именно так мы катили еще в 80-х.

Захватывающая задача моего независимого исследовательского проекта по ИИ состояла в том, чтобы анализировать и реагировать на предложения, которые включали простые глаголы и существительные. Например, я вводил предложения типа «У меня есть кот по имени Хэппи», «мой кот оранжевый» и «все кошки говорят мяу» в свою программу на LISP, что продемонстрировало бы некоторое понимание, отвечая на такие вопросы, как «Является ли Хэппи оранжевым?» или «кот Марка говорит мяу?». Как ни странно, я пытался создать чат-бота с искусственным интеллектом прямо на своем мейнфрейме Univac.

Бьюсь об заклад, многие другие студенты колледжа пытались сделать то же самое в то время, но никто из нас не продвинулся далеко, потому что это были 1980-е годы, и до нас еще не дошла одна ключевая блестящая идея: нейронная сеть, которая обеспечивает программное обеспечение. структура, предназначенная для выполнения массовых параллельных простых операций, подобных нейронам в человеческом мозгу. В то время как моя программа на LISP предоставляла однопоточные вычисления, а программы на Fortran, COBOL и Pascal следовали одной и той же ограниченной однопоточной парадигме, нейронные сети обеспечивали параллельные элементарные потоки, которые выполняли простые вычисления параллельно. Человеческий мозг выполняет большое количество параллельной обработки — одновременные операции каскадом создают иллюзию сингулярности — и структура программного обеспечения, известная как нейронная сеть, позволит программистам почерпнуть всю мощь этой параллельной обработки — после того, как я закончу колледж.

Наряду с концепцией нейронной сети в конце концов появилась концепция обучения нейронной сети повторяющимися действиями — еще одна концепция, которая еще не дошла до нас в 80-х годах. Я кормил свою программу LISP небольшим количеством полных предложений и не давал ей никакой обратной связи, с помощью которой можно было бы исправить и улучшить ее работу. Что я должен был делать, вместо того, чтобы вводить предложения в свой компьютерный терминал, так это скармливать ему целые книги, газеты и энциклопедии и постоянно взаимодействовать с ним, чтобы обеспечить обратную связь с его поведением, поскольку моя программа неоднократно пыталась имитировать самые основные, примитивные действия. понимания. Давая ему много материала для чтения, чтобы создать богатую и сложную базу знаний и многократно и тщательно тренируя его, я, возможно, фактически заставил свою компьютерную программу сказать что-то удивительное о том, есть ли у меня оранжевая кошка или нет. Нейронные сети и повторяющееся обучение, как оказалось, помогли проложить путь к успешному моделированию человеческого интеллекта, которое мы видим сегодня в чат-ботах.

Вы заметите, что я говорю о моделировании человеческого интеллекта. Это указывает на еще одно противоречие. Некоторые люди считают термин «искусственный интеллект» смешным. Хуже, чем нелепо, некоторые находят эту идею этически тревожной, потому что, если интеллект порождает сознание, искусственный интеллект может трансформироваться в искусственное сознание — искусственный разум, искусственная воля, искусственное право на существование. Это, черт возьми, действительно вызывает много экзистенциальных вопросов. Все эти вопросы актуальны и важны. Некоторые задаются вопросом, возможно ли, что двигатели знаний ИИ и языковые модели уже развивают сознание. Лично мне довольно легко заявить, что нет, нам не нужно беспокоиться о том, что чат-боты развивают настоящие чувства. Есть много разных аспектов ИИ, о которых нужно беспокоиться, и это не тот вопрос, о котором я беспокоюсь лично. Но это не значит, что я могу доказать, что я прав и что никто не должен об этом беспокоиться. Может быть, я просто настолько перегружен разными вещами, о которых мне следует беспокоиться, что у меня нет времени беспокоиться об этом. У меня нет окончательного ответа на все вопросы, которые могут возникнуть по поводу машинного разума, и я не собираюсь притворяться, что знаю. Но я знаю, какие вопросы нам нужно выяснить, как противостоять.

Одно из мнений, которые я иногда слышу в сообществах активистов, состоит в том, что ИИ представляет собой кучку шумихи — иллюзию, поддерживаемую отличными разговорными навыками большой языковой модели. Конечно, GPT может разобрать вопрос и ответить изящной фразеологией, но почему такое удачное использование языка заставляет нас воображать, что был достигнут какой-то значимый прогресс? Google и Википедия уже сделали все человеческие знания легко доступными бесплатно в Интернете, к ужасу Британской энциклопедии. Мы слышим всю эту шумиху вокруг ChatGPT просто потому, что он представляет собой лингвистический фасад человеческого сознания, иллюзию, в которую мы все так охотно влюбляемся. Я думаю, что здесь есть некоторая обоснованность. Может быть, если бы Google или Википедия изначально были запущены так внезапно и полностью сформированным образом, как ChatGPT, возможно, мы бы говорили о запуске Google или Википедии как о значительных достижениях в коллективном человеческом разуме, потому что они оба уже повлияли на наш мир.

Тем не менее, как я упоминал выше, когда говорил о нейронных сетях и обучении, описывать большие языковые модели как фасады означает недооценивать уровни структуры программного обеспечения, которые должны существовать, чтобы сделать возможным это лингвистическое благополучие.

На мой взгляд, это более важный вопрос: давайте рассмотрим этику OpenAI и ее руководителей, основателей, инвесторов и партнеров. Тут целая куча проблем.

OpenAI.com — это финансируемая из частных источников исследовательская лаборатория, возникшая из той же сверхбогатой и прибыльной экосистемы технологических инкубаторов Силиконовой долины, которая дала нам Facebook, Google, Microsoft, Amazon и Oracle. Среди ее основателей — Илон Маск, знаменитый миллиардер, чьи социопатические публичные высказывания вызывают у меня отвращение не меньше, чем у многих других людей. Илон Маск никогда не принимал непосредственного участия в OpenAI, и он перешел к другим вещам, таким как демонстрация своей оскорбительной личности во всех социальных сетях, так что это все, что я хочу сказать об Илоне Маске сегодня.

На мой взгляд, еще более убийственно то, что OpenAI тесно связан с Microsoft, крупным спекулянтом на войне и крупным спекулянтом в области искусственного интеллекта для войны. Я надеюсь, что люди будут беспокоиться об этой тревожной ассоциации даже больше, чем о связи с Илоном Маском. Мы должны быть очень обеспокоены тем, что дружелюбное лицо DALL-E и OpenAI является полезным фасадом, по крайней мере, для одного чрезвычайно влиятельного и злого военного спекулянта, Microsoft, которая уже разрабатывает виды военных и полицейских приложений искусственного интеллекта с расовым кодом, о которых мы говорили. о выше. Это уже происходит за кулисами Microsoft и других технологических гигантов США, которые тесно связаны с военной машиной США. И это худшие новости, которые я могу придумать.

Мы в антивоенном движении не можем отвернуться от искусственного интеллекта из-за его злого потенциала. Я не имею в виду, конечно, что все участники антивоенного движения должны допускать технологические вторжения в свою жизнь. Я рад, что многие прогрессисты и активисты сделали правильный выбор и отказались от модных технологических инноваций в своей жизни. Я могу понять и уважать такое отношение, хотя сам я далек от образа жизни, свободного от технологий. Технологии — это моя область, моя карьера, и как технолог я очарован гениальностью, творчеством и инновациями, стоящими за такими начинаниями, как искусственный интеллект.

Кроме того, просто как любопытный человек, я абсолютно заинтересован в том, чтобы получить представление о человеческом интеллекте, узнав о том, как были созданы компьютеры для его имитации. Я также впускаю ChatGPT в свою жизнь, потому что обнаружил, насколько он полезен. Я захожу на OpenAI.com и постоянно задаю ему вопросы. Я использую ChatGPT для написания кода, включая Javascript для новой версии нашей интерактивной карты иностранных военных баз США, над которой я работаю этим летом вместе с другими людьми из World Beyond War.

Допустим, я хочу очистить параметр строки запроса, удалив специальные символы с помощью регулярного выражения, что я бы использовал, чтобы спросить о переполнении стека, и я бы собрал свой рабочий код вместе из рекомендуемых фрагментов, опубликованных в ветке обсуждения. . Вместо этого я теперь говорю ChatGPT, что я хочу, и ChatGPT просто выдает идеально отформатированный Javascript, исполняемый и безошибочный. Большинство моих друзей-разработчиков программного обеспечения сейчас используют ChatGPT для написания кода — я знаю, что мы это делаем, потому что нам нравится говорить об этом. Я не думаю, что кто-то из нас, кодеров, пока не беспокоится о том, что ChatGPT заменит нас, потому что именно мы должны соединять фрагменты кода вместе для создания работающих систем, а GPT просто производит фрагменты кода. Но мне интересно, как это изменит то, как работают разработчики программного обеспечения. Это определенно уже меняет игру.

Я также использую ChatGPT для поиска информации в Интернете так же, как я использовал бы Google, и я использую его для подсказок, точек зрения и справочной информации о вещах, о которых я пишу или думаю. Я не шучу, когда говорю, что использую его для всего — например, когда я упомянул технологического философа 1960-х годов Маршалла Маклюэна выше, конечно, я попросил ChatGPT предоставить некоторую информацию о Маршалле Маклюэне, и именно ChatGPT сказал мне, что 1964 год был годом, когда он опубликовал книгу, в которой говорилось, что «средство есть сообщение».

Тот факт, что многие из нас уже перешли с Google на GPT для основного поиска в Интернете, говорит о многом. Очень легко начать позволять этим новым видам инструментов медленно и незаметно входить в нашу жизнь, даже если мы беспокоимся о последствиях и мотивах, стоящих за ними.

Подобно базовой программной технологии самого Интернета, которая была создана по сомнительным причинам американскими военными, но впоследствии вызвала социальные изменения и нашла новые варианты использования, которые полностью выходили за рамки ее первоначальной цели, эта новая технология будет найти свой собственный путь воздействия на нашу жизнь. Эта новая технология реальна, она работает слишком хорошо, чтобы ее игнорировать, и она никуда не денется. Опять же, именно поэтому я посвящаю эпизод разговору с антивоенными активистами — потому что это уже часть нашей реальности, и нам могут понадобиться некоторые из предлагаемых полномочий, чтобы выполнить нашу собственную работу здесь, на земле.

Давайте поразмышляем над многими аспектами жизни на этой планете, у которых нет тех ужасных проблем, о которых мы, антивоенные активисты, так хорошо осведомлены. Искусство, музыка, литература, биология, химия, физика, геология, астрономия, медицина, здоровье, производство, сельское хозяйство, питание. Во всех этих мирах, во всех этих начинаниях… публичный запуск высокоэффективного чат-бота с общими знаниями оказывает большое влияние. Нет поля, которого бы оно не коснулось.

На плане мирного человеческого сосуществования — плане, в котором я хотел бы проводить больше времени, существуя для себя — искусственный интеллект — это чудесное развитие человеческих способностей, которое обещает большие преимущества. Если бы мы жили в мирном, безопасном и справедливом мире, мы могли бы лучше вместе наслаждаться чудесами, которые может создавать искусственный интеллект.

Мы видим некоторые из этих чудес, когда работаем с генератором изображений и создаем потрясающе умные или творческие изображения на основе наших собственных подсказок, которые мы не смогли бы воспроизвести иначе. Мы также чувствуем парадокс относительно того, можно ли использовать инструменты искусственного интеллекта во благо. Как технарь, я считаю, что проблема планеты Земля в 21 веке не в технических инновациях. Я всегда приветствую технологические инновации, и я думаю, что опасности, которые представляет ИИ, связаны с укоренившимся капитализмом и войной — с тем фактом, что это планета воюет сама с собой, планета, на которой доминирует богатый 1%, который не может устоять самоубийственный путь построения военизированных крепостных обществ, которые подавляют других людей ради сохранения привилегий. Что нам нужно сделать, так это исцелить наше общество — чего нам не нужно делать, так это убегать от технологических достижений, потому что мы неправильно понимаем причины нашей агонии и нашего суицидального пути.

Вот что я думаю. Конечно, это не то, что думает каждый антивоенный активист, и это нормально. У нас были интересные реакции на World Beyond War список обсуждений по электронной почте – это живой и интеллектуальный форум, к которому я рекомендую всем присоединиться, просто нажмите на ссылку на нашем веб-сайте или выполните поиск world beyond war список для обсуждения — после того, как кто-то поделился действительно образными антивоенными образами, созданными с помощью DALL-E, а кто-то еще поделился удивительно полезными словами о том, как наша больная планета может найти пути к миру во всем мире.

Я считаю, что активисты должны овладеть всеми доступными технологиями – что активизм не должен ставить себя в положение менее способных к использованию передовых инновационных технологий, чем коррумпированные правительства и жадные корпорации, которые имеют привычку угнетать нас.

Я также считаю, что мы можем почерпнуть удивительные философские истины о человеческом сознании и человеческом существовании, изучая алгоритмы и шаблоны проектирования, используемые для его моделирования и симуляции. Всего несколько минут, проведенных с ChatGPT на веб-сайте OpenAI, могут раскрыть некоторые дикие истины о человеческой природе.

Вот одна дикая вещь, которую я все еще обдумываю. ChatGPT иногда врёт. Это делает вещи. Обычно вы не увидите этого, когда начнете задавать вопросы о GPT, потому что обычно он дает убедительный ответ на первый вопрос в беседе. Затем GPT не отстает от вас, когда вы задаете дополнительные вопросы, и здесь можно как бы загнать GPT в угол, где он начинает прямо лгать. Одним из первых вопросов, которые я когда-либо задавал ChatGPT, было рассказать мне о лучших антивоенных подкастах, потому что, естественно, мое эго было занято, и я хотел посмотреть, будут ли World Beyond War подкаст появится в списке.

Теперь, поскольку GPT предварительно обучен, то есть он был предварительно обучен и больше не обновляется с самыми последними новостями и информацией, поэтому я не ожидаю, что он будет знать много о моем маленьком подкаст. Я также не хотел искажать результаты, показывая GPT, что меня интересует один конкретный подкаст, поэтому я спросил его, есть ли отличные антивоенные подкасты, и он заверил меня, что они действительно есть. Затем я начал вдаваться в подробности, надеясь подтолкнуть его к названию World Beyond War подкаст, спросив — можете ли вы рассказать мне о подкастах, которые брали интервью у известных активистов, таких как Медея Бенджамин. Вот где вещи начинают становиться забавными. Как только система сделает заявление, она попытается подтвердить это заявление, поэтому после того, как она заверила меня, что действительно существуют подкасты, в которых брали интервью у Медеи Бенджамин, я попросил ее назвать один из этих подкастов, и затем она сказала мне, что Медея Бенджамин была ведущая собственного подкаста. Эм, это не она! Если бы она была, я бы, конечно, послушал ее. Мне удалось заставить ChatGPT солгать, загнав его в угол, где ему нужно было предоставить информацию, которой у него не было, поэтому он выдумывал информацию, которая звучала реалистично.

Это случается чаще, чем можно было бы подумать. Вы также можете легко уличить ChatGPT в ошибке, сообщив ему правдивую, но противоречивую информацию. После того, как GPT правильно сообщил мне, что Маршалл Маклюэн представил цитату «Средство есть сообщение» в 1964 году, я вспомнил, что этот блестящий и проницательный философ также написал своего рода ироническое продолжение своей предыдущей книги, в которой затрагивались более темные и тревожные вопросы. способы, с помощью которых средства массовой информации могут усыпить человеческий разум, пугающие популяции корпоративного массового контроля населения с помощью средств массовой информации — поскольку Маршалл Маклюэн действительно был таким удивительным, он понимал эту опасность еще тогда, в 1960-х годах, и опубликовал еще одну книгу в 1967 году с художником Квентином Фиоре. под названием «Среда есть массаж».

Итак, вот где все стало странно с GPT. Я попросил ChatGPT рассказать мне о цитате Маршалла Маклюэна «средство — это массаж»… и GPT категорически сообщил мне, что Маклюэн не сказал «средство — это массаж», а сказал, что «средство — это сообщение». Очевидно, GPT подумали, что массаж — это опечатка. Затем я сообщил GPT, что это неверно и что Маклюэн действительно сказал и «средство — это сообщение», и «средство — это сообщение». Как только я сказал это, ChatGPT осознал свою ошибку, извинился и сообщил мне, что да, «медиум — это массаж» — это книга, которую он написал в 1967 году.

Так почему же он ошибся первым, и особенно почему он ошибся, когда у него уже был доступ к правильному ответу в пределах его досягаемости? Ну, вот где GPT начинает раскрывать удивительные истины о нас самих, потому что на самом деле две ошибки или неправильное поведение GPT сделали его более человечным, а не менее. Помните, что G в GPT означает генеративный. Система предназначена для генерации ответов, когда она не уверена в правильности ответа. Он может сказать вам название фильма или книги, которых не существует, но это будет название, которое кажется возможным. Если у вас есть открытый длинный разговор с ChatGPT на любую тему, в которой вы много разбираетесь, вы быстро увидите, что он начинает делать ошибки.

То, как я смог загнать GPT в угол, задавая ему дополнительные вопросы к его собственным ответам, в конечном итоге заставив его генерировать реалистичную, кажущуюся, но ложную информацию в попытке подкрепить свои предыдущие утверждения, казалось мне не бесчеловечным, а основательным. человек.

Здесь мы видим грубую силу риторических и манипулятивных стилей аргументации. Возможно, что мы можем узнать из этого удивительного неправильного поведения ChatGPT, так это то, что по-человечески невозможно воспринять истину, не сфабриковав ее тем или иным способом, и если мы не будем осторожны, эти сфабрикованные истины, которые мы используем в риторических целях, могут стать ложью, которую мы вынуждены защищаться с большим количеством измышлений. Боже, мне это действительно кажется реалистичным.

Еще более реалистично: мы знаем, что человеческое поведение ChatGPT включает в себя ложь. И все же мы ему доверяем! Я даже сам продолжаю им пользоваться, потому что, действительно, я достаточно самоуверен, чтобы верить, что всегда смогу обнаружить, когда GPT напрягает ответ и выдает ложную информацию. Эй, может быть, я обманываю себя, и, возможно, мне следует подумать о своей собственной склонности верить сфабрикованным истинам и своей склонности позволять лгать другим.

Вот как GPT делает нас умнее, указывая на то, как мы сталкиваемся с неправдой, лицемерием, белоснежной ложью и дружеским обманом в наших нормальных человеческих отношениях. В двух словах: ChatGPT не может имитировать человеческое поведение без лжи. Это чертовски важно для всех нас, чтобы думать об этом.

Есть еще кое-что, о чем следует подумать: как мы, люди, успеваем идти в ногу с техническими инновациями, определяющими наше общество? В последние несколько лет мы приспосабливаемся к достижениям в области искусственного интеллекта, одновременно осваивая изобретение блокчейна, нового технологического метода создания общих баз данных с новыми концепциями владения, доступа и проверки. В предыдущем выпуске мы рассказывали о блокчейне, и я лично уверен, что большинство людей, которых я знаю, до сих пор не понимают, как блокчейн меняет нашу жизнь и изменит нашу жизнь в будущем — и теперь у нас есть широкий язык. модели и двигатели общих знаний, чтобы изменить нашу жизнь и наше будущее! Положи это на вершину, хм… куда мне вообще идти… проект генома человека, огромные достижения в науке о мозге, исследование и колонизация космоса… эй, люди, успеваем ли мы за всем этим?

Теперь давайте добавим технологические и научные споры о пандемиях, таких как COVID, и давайте не будем останавливаться на достигнутом, а продолжим рассмотрение ситуации с широкодоступным ядерным оружием в руках коррумпированных и некомпетентных так называемых правительств, управляемых стареющими бюрократами, и политиками. гарантированного взаимного уничтожения.

Следим ли мы за этим? Нет, но это дерьмо не отстает от нас, и у него есть наш номер. Каждое утро я просыпаюсь и читаю о опосредованной войне между НАТО и Россией, которая трагически убивает бедных людей, живущих в Украине. И каждое утро я задаюсь вопросом, не станет ли это днем, когда некомпетентность наших так называемых лидеров приведет к началу ядерной войны, — каждый день я задаюсь вопросом, является ли это последним днем человеческой жизни на планете Земля.

Жаркое лето 2023 года. Вышел новый фильм под названием «Оппенгеймер» об ученом, работа которого привела к невероятному ужасу мгновенного убийства сотен тысяч людей в Хиросиме и Нагасаки, Япония, в 1945 году. кому-то из нас еще удалось расширить свой разум настолько, чтобы осознать абсолютное зло, шокирующие, невыносимые истины об ошибках, которые совершило наше общество, и о нашей неспособности улучшить себя и подняться над нашей жалкой, постыдной общественной зависимостью от массовая ненависть и массовое насилие.

Выше я упоминал, что некоторые люди спрашивают, может ли искусственный интеллект привести к сознанию и/или разуму — может ли система ИИ когда-либо развивать эмоции и чувства, и что вообще означают эти слова и эти вопросы. Я еще не смотрел фильм «Оппенгеймер», и меня ужасно тошнит от мысли о фильме о массовых убийствах в Японии, в котором не показаны лица японских жертв. Вместо того, чтобы задаваться вопросом, разумны ли системы ИИ, все, что я хочу сказать, это то, что каждый человек, сожженный в Хиросиме и Нагасаки, был разумным и сознательным. Это правда, с которой, я думаю, нам еще не удавалось смириться. Может быть, нам нужно немного больше тренировать свои собственные умы на этом.

И на этом мы заканчиваем сегодня. Люди не могут смириться с правдой о проблемах, которые мы создали, и об изменениях, которые нам необходимо внести, чтобы стать лучше. Боты тоже не выносят правды. Спасибо, что разделили со мной это пространство, пока я размышляю о тайнах и парадоксах человеческого существования, и я собираюсь вывести нас с собой человеческим голосом певицы и автора песен, которую я любил долгое время, Шинейд О'Коннор, и песня под названием Healing Room. Спасибо, что прослушали 50-ю серию. До скорой встречи на 51-й.

World BEYOND War Подкаст в iTunes

World BEYOND War Подкаст на Spotify

World BEYOND War Подкаст на брошюровщике

World BEYOND War Подкаст RSS поток